文章目录

YOLOV5%E4%B8%8B%E8%BD%BD%E5%9C%B0%E5%9D%80-toc" style="margin-left:40px;">一、YOLOV5下载地址

二、版本及配置说明

三、初步测试

四、制作自己的数据集及转txt格式

1、数据集要求

2、下载labelme

3、安装依赖库

4、labelme操作

五、.json转txt、.xml转txt

六、修改配置文件

1、coco128.yaml->ddjc_parameter.yaml

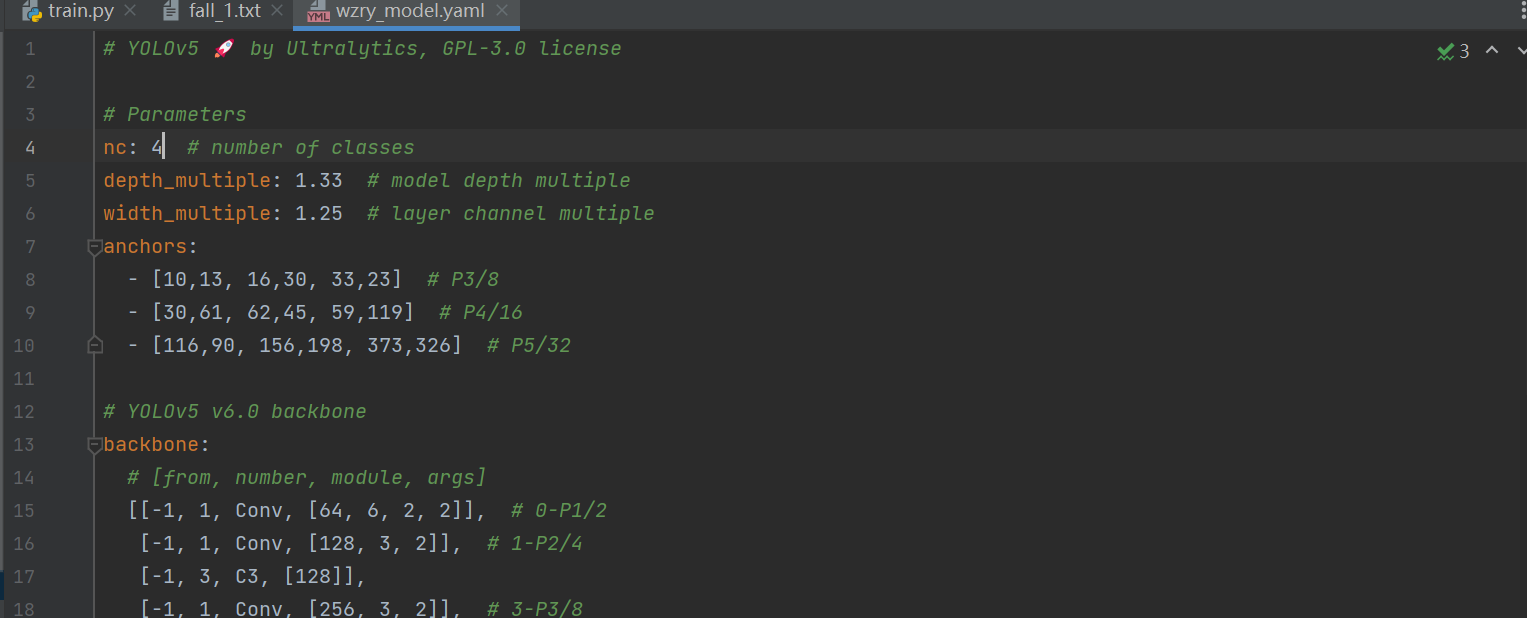

2、yolov5x.yaml->ddjc_model.yaml

八、调train和detect的参数并开始训练

1、在train.py,寻找函数def parse_opt(known=False),更改参数

2、train运行结果

3、在detect.py,寻找函数def parse_opt(),更改参数

YOLOv5是一种单阶段目标检测算法,该算法在YOLOv4的基础上添加了一些新的改进思路,使其速度与精度都得到了极大的性能提升。YOLOv5是Glenn Jocher等人研发,它是Ultralytics公司的开源项目。YOLOv5根据参数量分为了

n、s、m、l、x五种类型,其参数量依次上升,当然了其效果也是越来越好。从2020年6月发布至2022年11月已经更新了7个大版本,在v7版本中还添加了语义分割的功能。

YOLOV5%E4%B8%8B%E8%BD%BD%E5%9C%B0%E5%9D%80">一、YOLOV5下载地址

GitHub官方下载(推荐):https://github.com/ultralytics/yolov5

二、版本及配置说明

- 我是用cpu训练的,如果有条件的可以使用gpu进行训练,训练速度会相差10倍。

- 当然,用gpu下载pytorch的时候要下载cuda版本。

- 我采用的是Anaconda+Pycharm的配置,大家要了解一些关于pip和conda的指令,方便管理包和环境。

- 当我们下好yolov5后,可以发现有一个requirements.txt文件,使用Anaconda Prompt,切换到Yolov5的位置,pip install -r requirements.txt即可一步到位全部下完。下面是requirements.txt文件的内容。

# YOLOv5 requirements # Usage: pip install -r requirements.txt # Base ---------------------------------------- matplotlib>=3.2.2 numpy>=1.18.5 opencv-python>=4.1.1 Pillow>=7.1.2 PyYAML>=5.3.1 requests>=2.23.0 scipy>=1.4.1 # Google Colab version torch>=1.7.0 torchvision>=0.8.1 tqdm>=4.41.0 protobuf<4.21.3 # https://github.com/ultralytics/yolov5/issues/8012 # Logging ------------------------------------- tensorboard>=2.4.1 # wandb # Plotting ------------------------------------ pandas>=1.1.4 seaborn>=0.11.0 # Export -------------------------------------- # coremltools>=4.1 # CoreML export # onnx>=1.9.0 # ONNX export # onnx-simplifier>=0.3.6 # ONNX simplifier # scikit-learn==0.19.2 # CoreML quantization # tensorflow>=2.4.1 # TFLite export # tensorflowjs>=3.9.0 # TF.js export # openvino-dev # OpenVINO export # Extras -------------------------------------- ipython # interactive notebook psutil # system utilization thop # FLOPs computation # albumentations>=1.0.3 # pycocotools>=2.0 # COCO mAP # roboflows

三、初步测试

配置完成后,运行detect.py,如果一切正常,那么可以在runs/detect/exp中能发现被处理过的标签,就成功了,如果没有显示下图,那么可能是有的库的版本不对应,可以根据报错提示用pip uninstall 包后下载相应版本,要多试,因为有的库与库之间是相互联系的。

四、制作自己的数据集及转txt格式

1、数据集要求

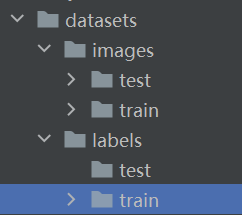

我的数据集为跌倒检测方面的,有1000张,上千张时处理后效果较好。

在yolov5中新建一个ddjc的文件夹,包含以下文件夹:

2、下载labelme

这个是对图片进行标注的工具

下载地址:GitHub - labelmeai/labelme: Image Polygonal Annotation with Python (polygon, rectangle, circle, line, point and image-level flag annotation).Image Polygonal Annotation with Python (polygon, rectangle, circle, line, point and image-level flag annotation). - labelmeai/labelme![]() https://github.com/wkentaro/labelme

https://github.com/wkentaro/labelme

下载压缩包后解压即可。

3、安装依赖库

在Anaconda Prompt里安装pyqt5和labelme,pyqt5是labelme的依赖项。

pip install pyqt5

pip install labelme4、labelme操作

然后在Anaconda Prompt里输入labelme,打开界面如下,右击,点击rectangle,即画矩形框,框选你要识别训练的东西。

框选之后输入标签的名字,注意,可以框选多个作为标签。框选完一张图后保存,然后接着下一张图。保存的文件格式是.json

五、.json转txt、.xml转txt

yolov5只识别txt,所以要将标注后的数据集转化为txt。

转换的时候可能会有问题,可以移步我的这篇博客统计XML文件内标签的种类和其数量及将xml格式转换为yolov5所需的txt格式-CSDN博客

我用的是公开的数据集,格式为.xml,转换时也遇到了目录和无法统计标签的过程,但都得以解决。

在你设置好的绝对路径下新建转换py文件,代码为:

.xml-txt

import xml.etree.ElementTree as ET

import pickle

import os

from os import listdir, getcwd

from os.path import join

import glob

classes = ['fall', 'no fall', 'no fall', 'nofall']

def convert(size, box):

dw = 1.0 / size[0]

dh = 1.0 / size[1]

x = (box[0] + box[1]) / 2.0

y = (box[2] + box[3]) / 2.0

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return (x, y, w, h)

def convert_annotation(image_name):

in_file = open('./labels/train1/' + image_name[:-3] + 'xml') # xml文件路径

out_file = open('./labels/train/' + image_name[:-3] + 'txt', 'w') # 转换后的txt文件存放路径

f = open('./labels/train1/' + image_name[:-3] + 'xml')

xml_text = f.read()

root = ET.fromstring(xml_text)

f.close()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

cls = obj.find('name').text

if cls not in classes:

print(cls)

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

bb = convert((w, h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

wd = getcwd()

if __name__ == '__main__':

for image_path in glob.glob("./images/train/*.jpg"): # 每一张图片都对应一个xml文件这里写xml对应的图片的路径

image_name = image_path.split('\\')[-1]

convert_annotation(image_name).json-txt

import json

import os

name2id = {'hero':0,'sodier':1,'tower':2}#标签名称

def convert(img_size, box):

dw = 1. / (img_size[0])

dh = 1. / (img_size[1])

x = (box[0] + box[2]) / 2.0 - 1

y = (box[1] + box[3]) / 2.0 - 1

w = box[2] - box[0]

h = box[3] - box[1]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return (x, y, w, h)

def decode_json(json_floder_path, json_name):

txt_name = 'C:\\Users\\86189\\Desktop\\' + json_name[0:-5] + '.txt'

#存放txt的绝对路径

txt_file = open(txt_name, 'w')

json_path = os.path.join(json_floder_path, json_name)

data = json.load(open(json_path, 'r', encoding='gb2312',errors='ignore'))

img_w = data['imageWidth']

img_h = data['imageHeight']

for i in data['shapes']:

label_name = i['label']

if (i['shape_type'] == 'rectangle'):

x1 = int(i['points'][0][0])

y1 = int(i['points'][0][1])

x2 = int(i['points'][1][0])

y2 = int(i['points'][1][1])

bb = (x1, y1, x2, y2)

bbox = convert((img_w, img_h), bb)

txt_file.write(str(name2id[label_name]) + " " + " ".join([str(a) for a in bbox]) + '\n')

if __name__ == "__main__":

json_floder_path = ''

#存放json的文件夹的绝对路径

json_names = os.listdir(json_floder_path)

for json_name in json_names:

decode_json(json_floder_path, json_name)转换完成后的txt文件:

第一个数字是数据集中第0个种类,其余均是与坐标相关的值。有几个标签就有几个种类。

六、修改配置文件

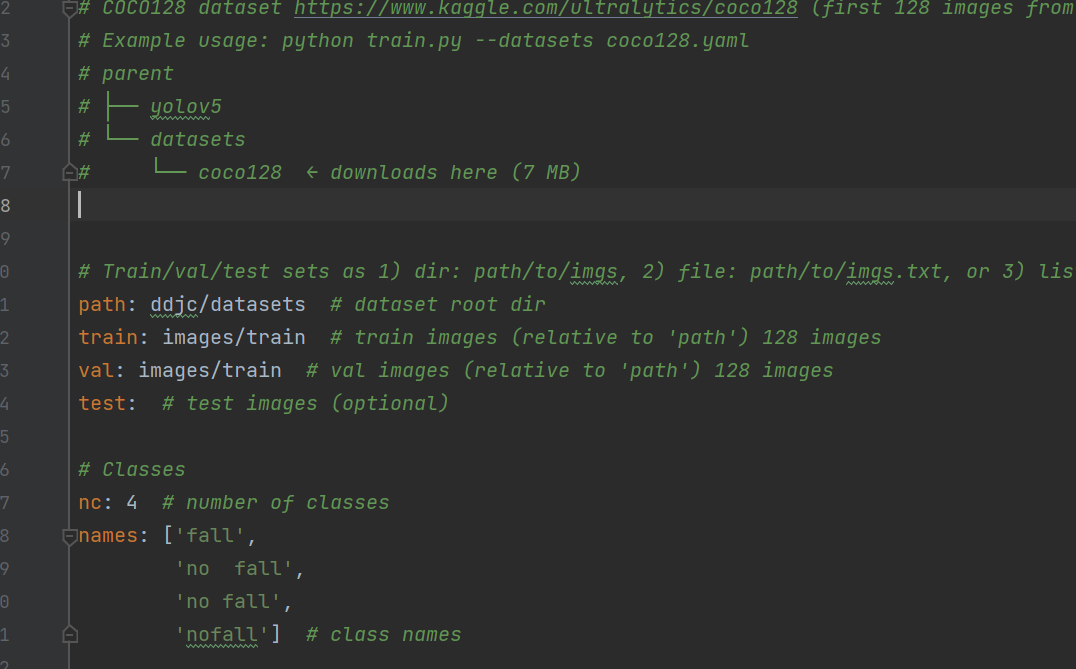

1、coco128.yaml->ddjc_parameter.yaml

在yolov5/data/coco128.yaml中先复制一份,粘贴到ddjc中,改名为ddjc_parameter.yaml(意义为ddjc的参数配置)

ddjc_parameter.yaml文件需要修改的参数是nc与names。nc是标签名个数,names就是标签的名字,跌倒检测有4个标签,标签名字都如下:['fall', 'no fall', 'no fall', 'nofall']

路径解释:如何正确使用机器学习中的训练集、验证集和测试集?-CSDN博客

2、yolov5x.yaml->ddjc_model.yaml

yolov5有4种配置,不同配置的特性如下,我选择yolov5x,效果较好,但是训练时间会很长。

在yolov5/models先复制一份yolov5x.yaml到ddjc,更名为ddjc_model.yaml(意为模型),只将如下的nc修改为标签的个数。

八、调train和detect的参数并开始训练

1、在train.py,寻找函数def parse_opt(known=False),更改参数

parser = argparse.ArgumentParser()

parser.add_argument('--weights', type=str, default='yolov5x', help='initial weights path') # 修改处 初始权重

parser.add_argument('--cfg', type=str, default=ROOT /'ddjc/ddjc_model.yaml', help='model.yaml path') # 修改处 训练模型文件

parser.add_argument('--data', type=str, default=ROOT /'ddjc/ddjc_parameter.yaml', help='dataset.yaml path') # 修改处 数据集参数文件

parser.add_argument('--hyp', type=str, default=ROOT / 'data/hyps/hyp.scratch-low.yaml', help='hyperparameters path') # 超参数设置

parser.add_argument('--epochs', type=int, default=50) # 修改处 训练轮数

parser.add_argument('--batch-size', type=int, default=16, help='total batch size for all GPUs, -1 for autobatch') # 修改处 batch size

parser.add_argument('--imgsz', '--img', '--img-size', type=int, default=384, help='train, val image size (pixels)')# 修改处 图片大小

parser.add_argument('--rect', action='store_true', help='rectangular training')

parser.add_argument('--resume', nargs='?', const=True, default=False, help='resume most recent training')

parser.add_argument('--nosave', action='store_true', help='only save final checkpoint')

parser.add_argument('--noval', action='store_true', help='only validate final epoch')

parser.add_argument('--noautoanchor', action='store_true', help='disable AutoAnchor')

parser.add_argument('--noplots', action='store_true', help='save no plot files')

parser.add_argument('--evolve', type=int, nargs='?', const=300, help='evolve hyperparameters for x generations')

parser.add_argument('--bucket', type=str, default='', help='gsutil bucket')

parser.add_argument('--cache', type=str, nargs='?', const='ram', help='--cache images in "ram" (default) or "disk"')

parser.add_argument('--image-weights', action='store_true', help='use weighted image selection for training')

parser.add_argument('--device', default='cpu', help='cuda device, i.e. 0 or 0,1,2,3 or cpu')#修改处,选择

parser.add_argument('--multi-scale', action='store_true', help='vary img-size +/- 50%%')

parser.add_argument('--single-cls', action='store_true', help='train multi-class data as single-class')

parser.add_argument('--optimizer', type=str, choices=['SGD', 'Adam', 'AdamW'], default='SGD', help='optimizer')

parser.add_argument('--sync-bn', action='store_true', help='use SyncBatchNorm, only available in DDP mode')

parser.add_argument('--workers', type=int, default=10, help='max dataloader workers (per RANK in DDP mode)')#修改处修改处的解释:

- 我们训练的初始权重的位置,是以.pt结尾的文件

- 训练模型文件,在本项目中对应ddjc_model.yaml;

- 数据集参数文件,在本项目中对于ddjc_parameter.yaml;

- 超参数设置,是人为设定的参数。包括学习率,不用改;

- 训练轮数,决定了训练时间与训练效果。如果选择训练模型是yolov5x.yaml,那么大约200轮数值就稳定下来了(收敛),我设置的50轮,因为这大概已经需要25h的时间了;

- 批量处理文件数,这个要设置地小一些,否则会out of memory。这个决定了我们训练的速度

- 图片大小,虽然我们训练集的图片是已经固定下来了,但是传入神经网络时可以resize大小,太大了训练时间会很长,且有可能报错,这个根据自己情况调小一些;

- 断续训练,如果说在训练过程中意外地中断,那么下一次可以在这里填True,会接着上一次runs/exp继续训练

- GPU加速,填0是电脑默认的CUDA,前提是电脑已经安装了CUDA才能GPU加速训练,安装过程可查博客,填cpu就是用gpu进行训练。

- 多线程设置,越大读取数据越快,但是太大了也会报错,因此也要根据自己状况填小。

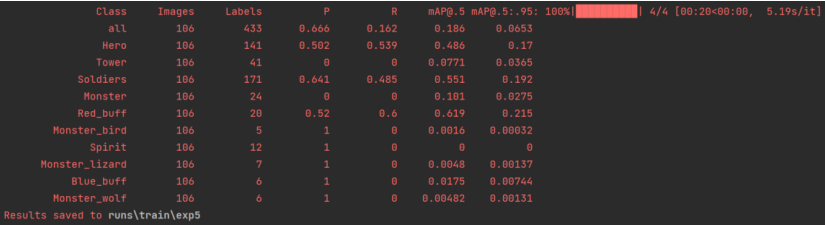

2、train运行结果

结果保存在runs/train/exp中,多次训练就会有exp1、exp2,我这里训练到第五轮了。

best.pt和last.pt是我们训练出来的权重文件,用于detect.py。last是最后一次的训练结果,best是效果最好的训练结果(只是看起来,但是泛化性不一定强)。

3、在detect.py,寻找函数def parse_opt(),更改参数

parser = argparse.ArgumentParser()

parser.add_argument('--weights', nargs='+', type=str, default=ROOT /'runs/train/exp7/weights/last.pt', help='model path(s)') # 修改处 权重文件

parser.add_argument('--source', type=str, default=ROOT /'wzry/datasets/images/test/SVID_20210726_111258_1.mp4', help='file/dir/URL/glob, 0 for webcam')# 修改处 图像、视频或摄像头

parser.add_argument('--data', type=str, default=ROOT / 'ddjc/ddjc_parameter.yaml', help='(optional) dataset.yaml path') # 修改处 参数文件

parser.add_argument('--imgsz', '--img', '--img-size', nargs='+', type=int, default=[640], help='inference size h,w') # 修改处 高 宽

parser.add_argument('--conf-thres', type=float, default=0.50, help='confidence threshold') # 置信度

parser.add_argument('--iou-thres', type=float, default=0.45, help='NMS IoU threshold')# 非极大抑制

parser.add_argument('--max-det', type=int, default=1000, help='maximum detections per image')

parser.add_argument('--device', default='cpu', help='cuda device, i.e. 0 or 0,1,2,3 or cpu') # 修改处运行结果在runs/detect/exp中。

九、我训练过程中存在并调试好的一些问题

请移步:YOLOv5训练过程中的各种报错-CSDN博客

希望能帮到大家,若需要数据集和训练好的模型,请留言。